Западные организации банят парсинг экономической информации

Это были на протяжении более 10 лет настроенные шаблоны выгрузки данных, настроенная и откалиброванная информационная среда, из которой сырые данные (в том числе и через API) поставлялись в собственные инфо-аналитические комплексы для обработки.

Также под бан попали действующий и резервный аккаунт с Yahoo_finance. Но с этими ублюдками сложнее. Там даже VPN и привязка к международному аккаунту не помогает «Sorry, this product is not available in the country where your account was created.»

Инфо-война в полный рост. Вся эта западная мразь считают, что на этом все закончилось? Нет, все только начинается!

***

Помнится несколько лет назад я организовывал «DOS» атаки на сервера Bloomberg и Reuters. Тогда были исключительно благие намерения – зеркалировать/реплицировать их корпоративные базы данных через легальный API доступ в рамках разрешенной информационной инфраструктуры.

Задача состояла в том, чтобы загрузить корпоративные отчеты по всем мировым компаниям за весь период публикации (с 1987 года) по всем корпоративным индикаторам в отчетности Income Statement, Balance Sheet и Cash Flow.

Обработать сверхбольшие массивы информации – нет проблем, к этому собственные технологии обработки данных были готовы. Задача была элегантно выгрузить. Поток запросов был максимально оптимизирован. Однако, тогда я с удивлением обнаружил, что в те времена (2013-2014) Reuters в отличие от Bloomberg практически не было защиты от сверх интенсивных запросов по источникам данных. Первый «транш» данных прошел достаточно быстро, но массив данных оказался сверхбольшим – свыше 800 Мб для группы компаний из 500 имен и по ограниченному списку индикаторов – лишь треть от необходимых.

Первый запрос не был достаточно оптимизирован. Пока готовил новый блок запросов, доступ к данным ограничивался – скорость обработки запросов резко упала. Ну ок, что поделать, работал с тем, что есть. От нескольких минут, запросы выполнялись за десятки минут. В итоге от глобальной корпоративной базы пришлось ограничиться американской, как наиболее приоритетной. И чем «глубже» работал с данными, тем больше было ограничений на загрузку. В итоге от идеи всех мировых компаний пришлось ограничиться выборкой по крупнейшим. И от идеи всех корпоративных индикаторов собрать лишь ключевые корпоративные индикаторы.

Но дальше был ад – даже небольшие выборки по 40-50 Мб данных выполнялись за несколько часов. А потом, запросы зависали даже для небольшого количества запросов. В итоге от автоматического режима пришлось вернуться практически к ручному. По сути, от 1 Гб данных в начале все вернулось к блоку данных в 2-3 Мб за запрос. Конечно, так корпоративные базы не зеркалируешь. Но я упрямый и продолжал это делать много месяцев по несколько мегабайт. Жаль, что сейчас это все похерелось. Я не был удивлен в подобном, это логично и естественно. Если бы я был системным администратором и видел DOS атаки на корпоративные базы, я бы поступил так же.

Удивило другое, видимо из сотен тысяч пользователей Bloomberg и Reuters только мне пришло в голову реплицировать их корпоративные базы! Иначе не объяснить, что в самом начале лимита на выгрузку практически не было. Все ограничивалось лишь потоком запросов. И ведь ценность Bloomberg и Reuters именно в корпоративных базах, т.к. макроэкономические можно получить практически бесплатно, если немного потрудиться.

Также я предполагал, что лично на мой аккаунт навесили тогда лимиты на загрузку, однако через несколько лет через партнеров по работе, я просил обновить БД на основе моих скриптов. Никак не связанные со мной аккаунты столкнулись с тем, что скорость обновления чудовищно низкая – примерно так, как в самом конце моего сотрудничества с Bloomberg и Reuters, т.е. по несколько Мб за запрос. А ведь в начале я им запустил червя в штаны чуть не на гигабайт залпом. Не знаю, связана ли была моя «DOS» атака с изменением глобальной политики по скачиванию данных с их серверов, однако точно помню, что в начале все было неплохо, а далее адские лимиты.

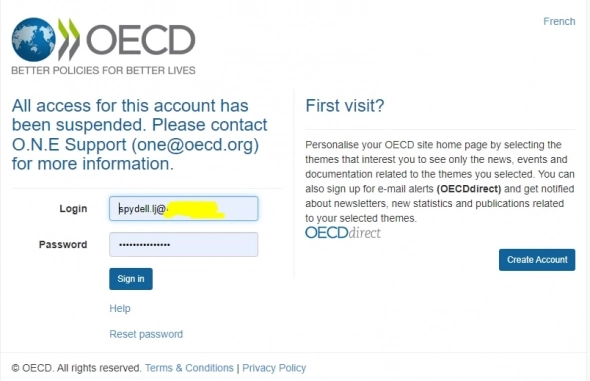

Сейчас с дата провайдерами все скверно. Практически все коммерческие поставщики данных на официальном уровне разрывают связи с Россией. Но даже государственные и международные это делают – ОЭСР, МВФ, ЕЦБ и другие. Судя по всему, делают это избирательно и подло – все мои аккаунты с настроенным шаблонами заблокированы. Можно создать новые, но это время, много времени, причем все равно это пойдет под блокировку рано или поздно. Ручная работа возможна, но не получится физически поставлять информацию в подобной интенсивности, как раньше.

Но пока работаю с тем, что удалось изъять у них (а в этом плане я безжалостен и забираю все, что можно забрать) и выстраивать инфраструктуру заново.

https://t.me/spydell_finance

Я так и делаю. С доступом во все дыры нет никаких проблем.

Продолжайте

Выгружайте с проверенных: ВестиРу, СоловьевЛайв, Царьград — там вам все объяснят без всяких выгрузок.

Государство вас вырастило, выкормило, а у вас никакой благодарности, все лезете не туда. Сталина на вас нет, он бы вас только за одно желание выгружать отправил на лес валить как врага народа

Бавовна пришла и сюда…

Сливать надо сырые данные, обрабатывать потом самостоятельно.

А что чем сложнее запросы тем медленнее — это норма.

Если доступ относительно открыт, то сливайте используя сотни или тысячи аккаунтов и ip. Делов то…

Сверхбольших это даже не 800тб...

Собирал куда как более простые вещи и там получались терабайты данных. А до обезжиривания десятки терабайт.