SMART-LAB

Новый дизайн

Мы делаем деньги на бирже

Блог им. Kot_Begemot

Нейронные сети и ученье о данных

- 22 февраля 2020, 22:12

- |

Когда вы занимаетесь искусственным интеллектом, то вам и в голову не приходит использовать нейронные сети! Да… такова их внутренняя сущность — к интеллекту они не имеют ровным счётом никакого отношения. В своё время NN (нейронные сети, Neural Networks) прочно ассоциировались со спиновыми стёклами — аналогом магнитной плёнки — на которую при желании можно записать ту или иную информацию. Да… в то время ещё не было ученых… как бы это правильнее перевести… ученых по данным… и в литературе часто можно было встретить выражение «образец, хранящийся в памяти сети». Другими словами, с самого своего рождения нейронные сети ассоциировались совершенно не с интеллектом, а с обычным хранилищем, своеобразной библиотекой.

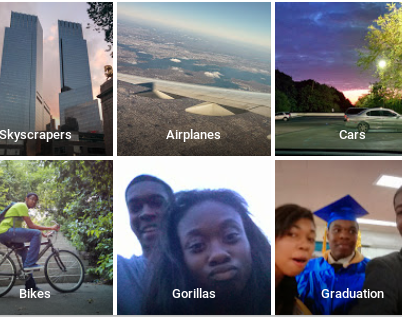

Всё «обучение» нейронной сети, в те времена, сводилось к тому, чтобы загрузить в её память наиболее репрезентативную выборку образцов, чтобы с ней, в конце-концов, не случилось конфуза и она не смогла бы с завидной регулярностью идентифицировать афроамериканцев как горилл, как это случилось у Data Scientist'ов из Google Photos. Поэтому, помимо школьной алгебры мы, как квалифицированные специалисты, изучали ещё и прикладной предмет, чтобы в любой момент, когда практика не согласовывалась бы с теорией, отметать… практику.

Классификация чернокожих людей от Google Photos.

У нас тогда ещё не было современных технологий позволяющих заменить учёных датасайнтистами так, чтобы не зная предмета можно было бы успешно с ним работать и поэтому нам приходилось ещё и учиться. Это сегодня, ученье о данных пренебрегает даже простейшими формами регуляризации «Out of Range» и полагает, что умеет экстраполировать. Мы же, в свое время, понимали, что всё обучение нейронной сети — это чистой воды overfitting (чтобы учёным по данным было понятно) или, говоря тяжёлым, непонятным языком — подгонка.

А чтобы сделать подгонку не просто «тупой», а… научной… нам требовалась непосредственная теория — о связи спроса и предложения, антропологических признаках человека и обезьяны, о физических процессах в твердых телах и протекании ядерных реакций — словом, в зависимости от задачи. Так, мы придумывали разные «фичи» или, говоря сложным, непонятным языком — принимали научные гипотезы, основанные на нашем научно-априорном знании о предмете, а потом приводили их в настолько формальный вид, чтобы нейронные сети могли с ними справиться. В этом, по-сути, и заключалась наша работа.

Другими словами, мы производили регуляризацию. Не стоит пугаться, что регуляризация (preprocessing) у нас была до «входа» и вообще до работы нейронной сети. Это только в ученье о данных существуют апостериорные регуляризации типа (L1, L2-тихонова и пр.), потому что именно оно, ученье о данных, не имеет никакого представления об объекте с которым работает, а для устаревших ВУЗовских наук — эти все регуляризации вообще не нужны, так как изначально все модели строятся и подгоняются правильно.

Иллюстрация применения науки ботаники, разделяющей растение на объекты-признаки (лист, цветок, стебель) при обучении нейронной сети.

Так, нам приходилось думать вместо «искусственного интеллекта», который за нами только запоминал и, таким образом, «обучался». Мы делали всё — структурировали данные, рассчитывали признаки, масштабировали, нормировали, делали «нарезки» и только после всех этих процедур, когда каждой «книге» в нашей «библиотеке» был по-сути присвоен свой, уникальный регистрационный номер, и искусственному библиотекарю уже просто негде было ошибаться, — в дело вступали нейронные сети.

Может быть, сегодняшние технологии шагнули далеко вперед и искусственный библиотекарь может теперь уже самостоятельно отличить роман от беллетристики, так что никакие литературоведы ему и подавно не нужны… разве что, обслуживающий персонал в виде учёных по данным. Но в наше далёкое время дело обстояло совершенно иначе.

теги блога Kot_Begemot

- API

- cpp

- FORTS

- LUA

- Matlab

- NASDAQ

- open source

- Quik Lua

- S&P

- S&P500

- S&P500 фьючерс

- Vanguard Group

- VIX

- акции

- акции США

- алгоритмы

- алготрейдинг

- анализ временных рядов

- баффет

- волатильность

- Гордон

- доверительное управление

- долги

- игры

- инвестиции

- индекc

- интеграция

- искусственный интеллект

- Келли

- Книги

- книги о трейдинге

- корреляция

- кризис

- криптовалюта

- лудомания

- Марковиц

- матлаб

- машинное обучение

- ММВБ Акции

- наука

- нейронные сети

- облигации

- одураченные случайностью

- оптимизация

- оптимизация торговых систем

- опционы

- оффтоп

- оционы

- памм счета инвестиции

- паника

- пирамида

- ПИФы

- портфели

- Портфель

- портфельное инвестирование

- пузыри

- раздача

- рецензия

- Риски

- рэнкинг мосбиржи

- Сбербанк

- спекуляции

- статистика

- стоимостное инвестирование

- талеб

- теги не нужны

- теория игр

- торговая система

- торговые роботы

- трейдинг

- улыбка волатильности

- управляющая компания

- финанализ

- фундаментальный анализ

- фьючерс ртс

- Шарп

- шутка

- Экономика

Кстати, открою свою маленькую тайну — все это прекрасно работает в качестве обучаемой логики. ПЛМ, если хотите.

Шахматы, старкрафт, дота, ГО, автопилот в автомобилях, постановка диагнозов...

Интеллектом пока не пахнет, но это всего лишь 2020 год.

Маловероятно, что в SCII играют нейронные сети. MicroMachine и др. «игроки» даже близко не напоминают работу NN, а отрабатывают заданные алгоритмы, те же «сети», что обучаются у людей — нереально тупят, эмитируя деятельность профессиональных игроков без результата (потому что не понимают смысла их действий), но за счёт супер микро… шансов против них не так уж и много.

Шахматы не используют NN, покерные боты тоже не строятся на NN и тому-подобных алгоритмах.

Собственно, речь не об AI, потому что шахматных, покерных и прочих игроков я очень уважаю, речь о том, чего не стоит ожидать от нейронных сетей и как с ними работать.

ИИ должен был отфильтровать такое сразу… или присмотреться… а по факту дикая пробка, когда проезжали 5 машин в минуту…

Как Google отреагировал на парня, который имитировал пробки при помощи тележки и 99 телефонов?4 февраля158 тыс. дочитываний40 сек.176 тыс. просмотров. Уникальные посетители страницы.158 тыс. дочитываний, 90%. Пользователи, дочитавшие до конца.40 сек. Среднее время дочитывания публикации.

Ранее мы писали, как художник Саймон Векерт обманул карты Google, создав на них пробки. Для этого он медленно перемещал в тележке 99 смартфонов с запущенными Google Maps. Теперь у нас есть официальное заявление от Google относительно «взлома» карт Google, подробно описанного в оригинальной статье ниже. Теперь у нас также есть некоторая ясность относительно того, как художник выполнил «взлом».

В интервью для немецкой газеты Frankfurter Allgemeine художник Саймон Векерт рассказал, что у каждого из 99 смартфонов в тележке была своя собственная SIM-карта, и каждый активно использовал Google Maps для навигации. Он обнаружил, что если тележка перестанет двигаться, на Google Maps не появится пробка, поэтому тележка должна постоянно двигаться, чтобы пробка зафиксировалась в сервисе.

Кроме того, если транспортное средство проезжало мимо тележки с нормальной скоростью, карты также регистрировали движение в обычном режиме. Только когда тележка двигалась, а улица была пуста, на Google Картах появлялись пробки.

Google ответил в ответ на «взлом» с использованием 99 смартфонов и регистрацией ложных пробок:

Компания также подтвердила свое стремление сделать Карты максимально точными. Google также насмешливо указал на то, что он может различать автомобили и мотоциклы в некоторых регионах мира, но еще не определил формулу тележек.

Что до искусственных нейросетей, то они тоже весьма далеки до естественных. Фактически это система сжатия N-мерной таблицы. Например, обычная двумерная таблица это нейросеть с двумя входами и одним выходом. Только она видит какую-то закономерность в организации данных, например, соседние ячейки таблицы ничем не отличаются, значит можно сократить объем информации в этом месте и т.д.

ru.m.wikinews.org/wiki/%D0%A2%D0%B5%D1%81%D1%82_%D0%A2%D1%8C%D1%8E%D1%80%D0%B8%D0%BD%D0%B3%D0%B0_%D0%BF%D1%80%D0%BE%D0%B9%D0%B4%D0%B5%D0%BD

Может быть дело в кажущейся лёгкости. До рождения детей я думал что большой разницы между человеком и кошкой нету. Мозг у тех и других, какие-то мысли, желания. Но собственные дети за пару тройку лет наглядно демонстрируют пропасть между человеком и животными. Когда например понимают что чёрточки и пятна на бумаге это реальные объекты и объединяют их в классы. Дальше, больше. Собаки и кошки, невероятно тупы. При этом кое какой интеллект у них есть. Больше чем у крокодилов или птиц. Но в шахматы они у вас не выиграют, это очевидно. А ваш смартфон может.

ivanovr, может быть, это просто доказывает, что русский язык черезчур сложен?..

Как известно, "Косил косой косой косой".

С точки зрения интеллекта человека NN очень нерациональны в плане обучения.

Ассоциировать нейросети с искуственным интеллектом тоже мало кому приходило в голову. Тут вы что-то своё придумали.

Но свое основное развитие нейронные сети получили именно как системы активной памяти и аналогий стат-физики (метод имитации отжига, спиновые стёкла и др.). После чего возникли self-organizing maps и рекуррентные сети, был разработан мат. аппарат, рассчитывающий память нейронных сетей и т.д.

При этом, именно подход к NN как к системам активной памяти сосредоточил внимание на задачах распознавания образов путем их сверки с образами из памяти сети.

Аналогично задача регрессии в тех же RF решается через задачу классификации, а задача классификации через задачу памяти. Дерево «помнит»… область пространства ( в задачи регрессии) как эталонный образец из памяти и выдает вам номер, название, целевую функцию, изображение — любой объект соответствия по «карте» пространства.

Это, грубо говоря, то же самое, что спросить у карты что находится на уровне 90* широты, 30* долготы.

Я бы сказал иначе. Как, например, человек думает перед тем как построить дом? Он знает, что дом может покосить от ветра, подмыть грунт водами, и т.д. и т.п. То есть решается задача максимума надёжности в условиях ограничений, наложенных стихийными бедствиями.

Нейросеть нельзя научить строить дом (рассчитывать дом в этих ограничениях), она может только повторять ранее увиденные дома и различные их комбинации. А здесь нужно заниматься именно расчетом, схожим с расчетами в покере — то есть искать такую инженерную конструкцию так, чтобы при любых, неблагоприятных погодных условиях она выполняла свою функцию.

А для того чтобы это делать — нужно моделировать, хотя бы в уме. Моделировать наводнения, землетрясения, вспышки волатильности, кризисы и тренды… И тренировать «сеть» (алгоритм) на смоделированных сигналах. Как это делается, например, в играх/теории игр.

Вероятно, этим и отличается наш мозг — он мешает собственные фантазии с реальностью и этим проявляет собственную интеллектуальность. А подстройка под историю… это условные рефлексы только, как у собаки Павлова.

В антропологии, например, широко распространено несколько иное мнение о том, что собака моделирует (подбирает) собственное поведение, а человек — среду своего обитания. Вот… можно сказать, неблагоприятную среду мы и моделируем, как в GTO.

Вероятно, ничего. Но, если мы посмотрим, например, на математику, как абстрактную науку, науку вне опыта, вне эмпириокритицизма, то мы можем заметить, что человеческий ум способен двинуться далее чем просто операции с наблюдениями (памятью). Он как минимум способен предполагать о существовании некоторых абстрактных объектов (модель атома, нейтрино, точка, прямая, луч) и уже с ними оперировать.

Вот тут диалектика такая получается — вроде как мы знаем и оперируем только тем, что дано нам в ощущениях (памятью), а вроде и нет.

Это вопрос не из праздных, как видите, гносеология занимается им по крайней мере уже 500 лет. На этот тонкий момент — склонности к абстрактным моделям (например линейной регрессии и т.д.) указывает В.И. Ленин при разделении философов на материалистов и идеалистов-критицистов, маскирующихся под учёных-эмпирических исследователей.

Если говорить языком ML, то здесь проводится грань между запоминанием и восстановлением регрессии на данных (NN) и абстрактной моделью, восстанавливающий регрессию вне данных (вне области определения), то есть разницу между интерполяцией и экстраполяцией.

Когда Boosting только появился, например, то многие его противники (и я в том числе) называли его не более, чем overfitting. Почему? Потому что он тупо запоминает все значения и восстанавливает ту же линейную регрессию не в виде абстрактной функции, а в виде адреса памяти — «я помню, что для уравнения y=x, при x от 1 до 2, y приблизительно равен 1.5!». У такой «тупой» памяти (карты местности) абсурдно спрашивать чему будет равен y при x принадлежащим (7,10). То же относится и к нейронным сетям.

Но это только одна линия разделения ума и памяти. ГСЧ же здесь нужен как драйвер, некоторая сила, вынуждающая усаживать и усаживать память, сжимать её, выталкивая из одного локального минимума в другой.

Kot_Begemot, Чтобы написать первому вам в ЛС нужен рейтинг, которого у меня нет. Может телеграмм или вы мне напишите в личику?)

В ином случае придется захламлять смартлаб любительскими статьями, чтобы заработать минимальный рейтинг для переписки с вами =)