Избранное трейдера Роман Давыдов

Обратный пропорциональный спред - мощь и красота

- 27 июля 2017, 19:18

- |

Для спецов в опционах сегодня я могу поделиться опытом использования обратного пропорционального спреда. За последнее время это наиболее популярная конструкция в моей торговле (направленная торговля опционами), и расскажу почему.

Обратный пропорциональный спред активно применяется мной по следующим причинам: по наблюдениям даёт хороший прирост цены (обычно выше, чем участвующие в нём опционы на его страйки по отдельности), а также хорош для управления позицией.

Не буду рассказывать теорию, а поделюсь практикой.

Вообще я читал в западных источниках, что такая конструкция подходит, когда вы ожидаете например резкий рост на БА, но его вероятность — невысокая. Тогда типа покупай такую конструкцию за практически 0 – в случае роста цены на БА вы получаете хорошую прибыль, а если его не происходит – то цена опциона не меняется да и вы ничем не рисковали, в смысле не было ваших расходов. Например, это подходит для биотеха, если ждете прорыва у какой-то компании, выдачи разрешения FDA и т.п.

( Читать дальше )

- комментировать

- ★51

- Комментарии ( 52 )

Скрипт на qlua - Светофор

- 16 мая 2017, 22:14

- |

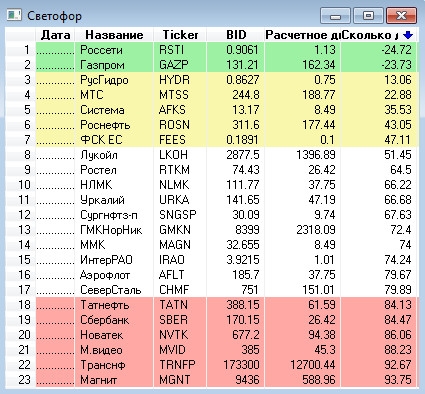

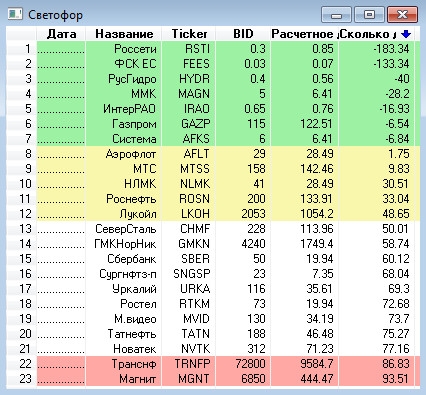

По следам этого поста скрипт на qlua, называется «Светофор».

Суть скрипта- отслеживать дистанцию до «дна», которое представляет собой лои 2008 года+накопленная инфляция.

Подсветка строк:

зеленым- цена ниже уровня инфляции

желтым — до дна менее 50%

красным — до дна более 80%

сортировка строк по ctrl+клик

В чем не смог разобраться:

как получить лой 2008 года по акции (вбито вручную)

как получить полное название компаний (вбито вручную)

кто знает — подскажите!

Как это выглядит в Квике:

Бэктест на проливе 2014 года:

( Читать дальше )

Предсказание курса акций Газпрома с помощью нейронной сети на R

- 07 мая 2017, 10:43

- |

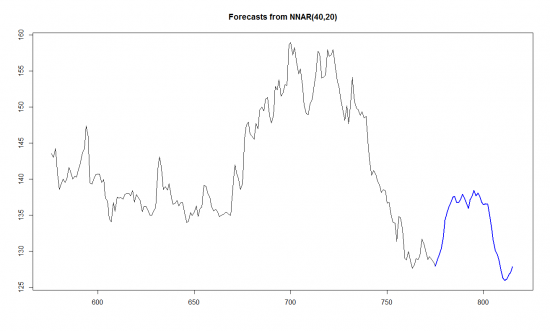

Итак, я взял историю с 2014 года, обучил нейронную сеть на дневных данных акций Газпрома и попробовал предсказать поведение цены на апрель.

Синяя линия — это предсказание динамики. Нейронная сеть думала, что будет двойное дно, после чего цена пойдет примерно на 137.

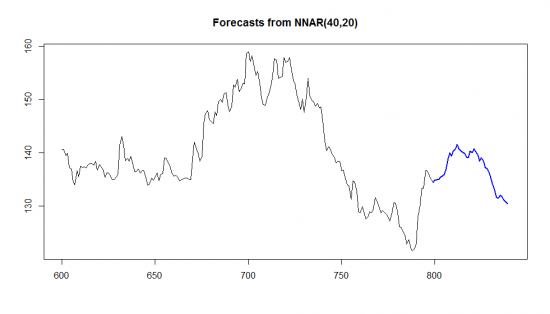

А вот что было на самом деле. В следующем графике уже предсказание на май и видно, что было в апреле.

( Читать дальше )

Вычисление косинуса угла с помощью нейронной сети на R

- 23 апреля 2017, 20:48

- |

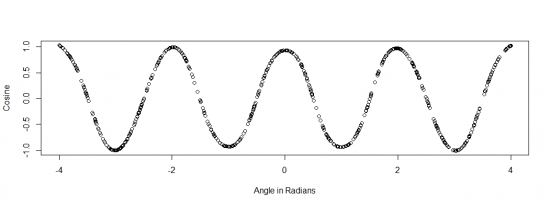

Я взял 100 равномерно распределенных случайных чисел в промежутке от -4 до 4 Pi и научил по этим данным нейронную сеть, состоящую из 10 скрытых нейронов вычислять косинус угла. Вот что в итоге получилось, когда я вычислил 600 значений между -4 и 4 Pi.

Не плохо, правда? Нейронная сеть не знает ничего о том, что такое косинус, она не знает, зачем он нужен, в чем его геометрический смысл, какое у него разложение Тейлора и тд. И тем не менее, она научилась его вычислять.

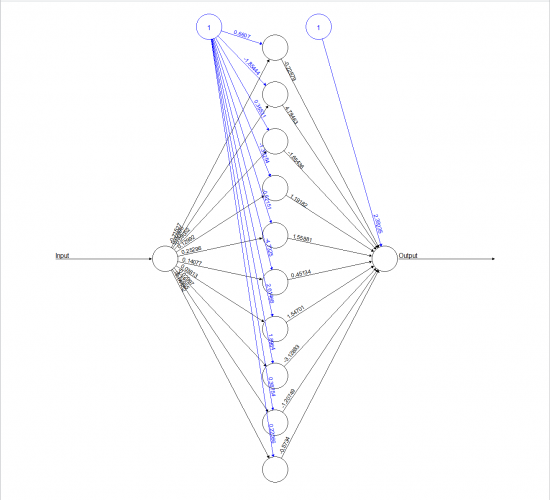

Выглядит сеть примерно так:

( Читать дальше )

Бектест трендовой торговой системы на R

- 23 апреля 2017, 14:59

- |

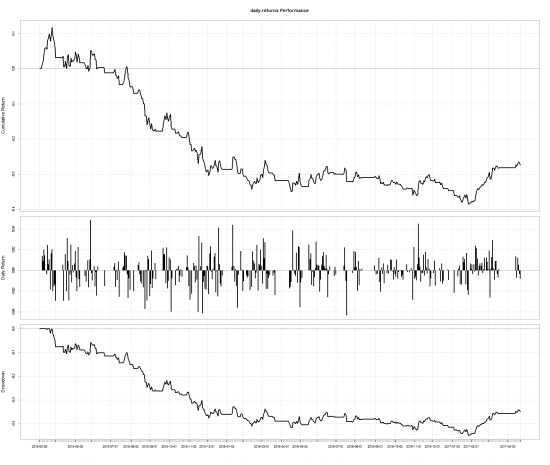

Протестируем эту стратегию на акциях Газпрома с 2015 по 2017 год с использованием R.

Результат: эквити, дневные доходности и просадка. Как видно, в результате такой торговли мы бы потеряли 35% счета.

( Читать дальше )

Как я писал бота на теннисные ставки

- 05 апреля 2017, 21:38

- |

Хочу поделится некоторой инфой по этой теме. Если у вас был подобный опыт с удовольствием бы прочел!

Тема довольна интересная, тем более что крупнейшие букмекерские конторы предоставляют API для ставок. У меня была пару подходов к этому. Сначала я наверно как и все решил что буду арбитражить на разных площадках ставки, подобные ставки называются «вилки», написал бота и попробовал. Однако Букмекеры подобных деятелей сильно не любят, и довольно легко вычисляют, после пары сделок мне на «Марафоне» порезали лимиты до 20 рублей на ставку.

После мне пришла идея попытаться использовать машинное обучение для направленной стратегии угадывания победителя в матче. Погулил и пришел сюда https://habrahabr.ru/post/306944/. Решил что с приемлемыми трудозатратами сделать это быстро не получится, решил воспользоваться готовым сервисом, который дает прогнозы на предстоящие матчи. Остановился на этом

( Читать дальше )

Плеер опционных позиций. OptionTesterFVV. Версия 1.

- 18 февраля 2017, 20:18

- |

Теперь тест опционных стратегий на истории возможен ;)

Хочу поделиться с вами давнишней моей прогой, но чрезвычайно важной и без преувеличения уникальной. Я не видел еще таких плееров у нас в России, может они конечно и существуют, но както не попадались на глаза.

Тестирование опционных стратегий очень сложная задача. Может кто помнит, я выкладывал тесты простых конструкций, посмотреть можно тут.

Каждый тест, это по сути, отдельно написанная программа. Когда я протестировал основные комбинации, встал вопрос тестирования методов роллирования. Методов роллирования просто не счесть и я понял, что для этих целей старый подход тестирования никуда не годится, иначе я бы рисковал погрязнуть в бесконечном круге программирования этих методов. В итоге решил сделать плеер. С помощью плеера можно протестировать любую идею роллирования опционной конструкции и ничего не надо программировать заново.

Для чего плеер нужен (для чего применяю его я):

( Читать дальше )

Опционы si. Грааль бесплатно.

- 14 февраля 2017, 14:27

- |

На страйке покупаем стрэддл марта. Например, 100 колов + 100 путов. Ждем, когда сишка завалится копеек на 40-50 (как раз отобьется дневная тета) и ровняем дельту покупкой колов на новом центральном страйке. На развороте ловим рубля три, все хозяйство кроем и наслаждаемся

Дивиденды2017.Конкурс: Дивидендные воздушные замки

- 05 февраля 2017, 17:58

- |

Прежде всего хочу вас поздравить с наступлением НОВОГО ДИВИДЕНДНОГО ГОДА! СД Северстали первым в дал рекомендации по размеру дивидендов по итогам 2016 года. Цитирую:

МОСКВА, 1 фев — ПРАЙМ. Совет директоров "Северстали" рекомендовал акционерам утвердить дивиденды по итогам четвертого квартала 2016 года в размере 27,73 рубля на одну обыкновенную акцию, говорится в сообщении компании.

Вопрос о дивидендах будет вынесен на рассмотрение годового собрания акционеров, которое запланировано на 9 июня 2017 года. Дата закрытия реестра – 15 мая. В случае одобрения дивидендов реестр на их получение закрывается 20 июня 2017года

Всего на выплату дивидендов может быть направлено около 23,23 миллиарда рублей, из которых на долю основного акционера (79,2% акций) «Северстали» Алексея Мордашова приходится, соответственно, порядка 18,4 миллиарда рублей.

«Магнит» направит на выплату дивидендов в 2017 г. не меньше 30 млрд руб., сообщил гендиректор компании Сергей Галицкий в ходе телефонной конференции.

( Читать дальше )

Опционы по взрослому (улыбки распределения)

- 09 января 2017, 21:41

- |

Мы остановились на подгонке дельты БА и нормального распределения. Почему БШ взял его? Да другого и не было. Во всем виновата «Центральная предельная теорема» Ее смысл, коротко: «сколько веревочке не виться, а депо сольется» То есть, любое распределение, похожее на нормальное, рано или поздно таким станет. Приращения цены, как бы должны заполнить купол или колокол распределения. Соответственно, если мы накроем опционом определенный сектор цены, будет нам профит. Но, что то пошло не так.

Я специально хочу вас протащить по истории вопроса, что бы вы смогли разобраться во всех проблемах опционов. Файл: https://cloud.mail.ru/public/db9v/9Mzo1jdL3

Мы дошли до конца, когда необходимо писать формулу БШ. Что бы подключить время и цены. Она не такая и страшная. Первое что надо понять это d1 и d2. Исходники: Сколько дней в году, свечи в году. Сколько дней (свечей дневных) до эксперы. Волатильность центрального страйка, про которую думают что она правильная. В БШ оперируют относительными величинами. Поэтому, я часто перевожу их в проценты, что бы было нагляднее. Что бы получить долю 30 дней времени в году 30/246. Или 12% от года или 0,12. Итак смотрим d1=ln(БА/страйк)(это отношение между БА и Страйком, если хотите в процентах)+0,5(для кола и 0,5 для пута. Потом, вместе это станет 1 дельтой)*волатильность в квадрате(квадрат это второй момент, волатильность в годовом выражении)*долю времени до эксперы(в процентах)/волатильность*корень из доли времени(корень, потому что так надоJ)). Все. Можно знаки поменять, отнимать 0,5… и получить d2 мне удобнее от d1-волатильность*корень из времени.

( Читать дальше )

- bitcoin

- brent

- eurusd

- forex

- gbpusd

- gold

- imoex

- ipo

- nasdaq

- nyse

- rts

- s&p500

- si

- usdrub

- wti

- акции

- алготрейдинг

- алроса

- аналитика

- аэрофлот

- банки

- биржа

- биткоин

- брокеры

- валюта

- вдо

- волновой анализ

- волны эллиотта

- вопрос

- втб

- газ

- газпром

- гмк норникель

- дивиденды

- доллар

- доллар рубль

- евро

- золото

- инвестиции

- индекс мб

- инфляция

- китай

- кризис

- криптовалюта

- лукойл

- магнит

- ммвб

- мобильный пост

- мосбиржа

- московская биржа

- мтс

- нефть

- новатэк

- новости

- обзор рынка

- облигации

- опрос

- опционы

- отчеты мсфо

- офз

- оффтоп

- прогноз

- прогноз по акциям

- путин

- раскрытие информации

- ри

- роснефть

- россия

- ртс

- рубль

- рынки

- рынок

- санкции

- сбер

- сбербанк

- северсталь

- си

- сигналы

- смартлаб

- сущфакты

- сша

- технический анализ

- торговля

- торговые роботы

- торговые сигналы

- трамп

- трейдинг

- украина

- фондовый рынок

- форекс

- фрс

- фьючерс

- фьючерс mix

- фьючерс ртс

- фьючерсы

- цб

- цб рф

- экономика

- юмор

- яндекс

Новости тг-канал

Новости тг-канал